CIENCIA DE LA SEMANA

Grandes datos, grandes sesgos

Los sistemas de inteligencia artificial no solo absorben nuestros prejuicios racistas y sexistas, sino que los amplifican y los usan en secreto

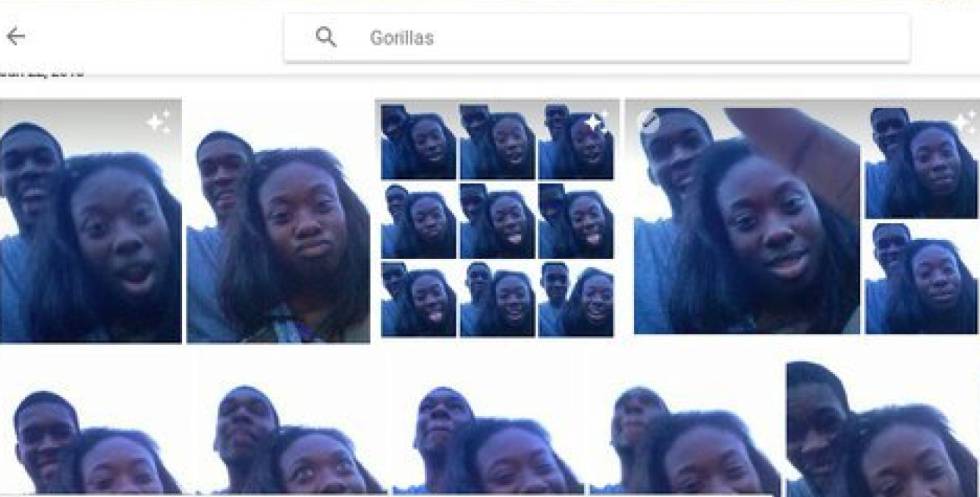

Un algoritmo de Google Foto etiquetó a negros como gorilas en 2015.

Tanto preocuparnos por los peligros de la robótica y la inteligencia artificial, por los ejércitos de soldados autómatas que nos amargarán el futuro, por los riesgos de la automatización que podemos imaginar —y sobre todo por los que no podemos ni imaginar— y resulta que nos estamos olvidando de un problema bien gordo que ya está entre nosotros: los sesgos racistas y sexistas de las máquinas. Lee en Materia un espeluznante artículo que revela esta amenaza cierta con el fulgor deslumbrante de una revelación.

Bien pensado, no es extraño que las máquinas tengan prejuicios irracionales: los han aprendido de nosotros. Una red neural típica (un software que abstrae conceptos de la experiencia) aprende inglés o español empollándose varios millones de textos y discursos escritos o pronunciados por miríadas de Homo sapiens. Una variedad particularmente útil de estos sistemas se basa en un espacio vectorial donde cada palabra es un vector y los conceptos emergen de la proximidad de dos palabras en un texto. Si “gitano” aparece a menudo a menos de diez palabras de “marginal”, la máquina aprenderá a asociar esas dos ideas. Es decir, absorberá de nosotros ese sesgo inaceptable.

Si “gitano” aparece a menudo a menos de diez palabras de “marginal”, la máquina aprenderá a asociar esas dos ideas

Con las imágenes ocurre algo muy similar. Si las mujeres aparecen a menudo junto a una cacerola, la red neural deducirá el equivalente en silicio de “la mujer a la cocina”, un concepto de gran alcance que las personas de carne y hueso hemos tenido grabado en nuestros circuitos durante milenios, y que sigue presente incluso en los que creemos haberlo superado. Nadie ha programado a la red neural para ser sexista ni racista, pero la máquina es extraordinariamente eficaz asimilando esos sesgos de nuestros prejuicios inconscientes. Grandes datos, grandes sesgos.

El problema es muy serio, y se nos está escurriendo entre los dedos con el automatismo con que aceptamos un desastre natural. Un robot tuitero de Microsoft llamado Tay aprendió con tal solvencia los usos y costumbres de esa red social que empezó a tuitear apologías de los nazis, a defender el muro antimexicano de Donald Trump y a acosar a cualquier humano ingenuo que se le ponía a tiro. Los de Bill Gates tuvieron que retirar a Tay de la circulación a las 24 horas de su presentación en sociedad. Ojalá todos los cazurros de Twitter tuvieran una vida tan corta. Y hay hazañas de la inteligencia artificial más preocupantes aún.

Google confunde a los afroamericanos con gorilas, y Flickr con chimpancés, y llegaron a llamar “la casa del negro” a la Casa Blanca de Obama. La cámara de Nikon rechaza fotografiar a un chino porque cree que está parpadeando. Amazon excluye de sus promociones a los barrios de mayoría negra como Harlem. “Armas de destrucción matemática”, las ha llamado la científica de la computación Cathy O’Neil, que denuncia el control secreto que ejerce el big datasobre cuestiones tan vitales como ser aceptado por una universidad, solicitar una hipoteca, encontrar un trabajo o comerse el marrón de una pena de prisión.

El problema es grave. Lee Materia y entra en el debate.

No hay comentarios:

Publicar un comentario